単回帰分析モデルの定式化

前回、単回帰分析は、データに上手く当てはまるような直線を引いていると説明した。つまり、 によって説明される

によって説明される の真の状態(期待値)は、

の真の状態(期待値)は、 の一次関数であると仮定している:

の一次関数であると仮定している:

ところで、

は

正規分布に従うと仮定しているので、期待値

![E[ y | x ]](https://chart.apis.google.com/chart?cht=tx&chl=%20E%5B%20y%20%7C%20x%20%5D)

の周りでばらつくと考えていることになる。そのばらつきの部分を「誤差項」といい、

で表す。したがって、

は期待値に誤差を加えて

という構造になっている(と想定している。もちろんこの表現が必ずしも現実を上手く説明できるかは分からない)。この数式を単回帰分析モデルと言う(一般に、

統計学的な方法によってデータの振る舞いを説明する時、そのような数式表現を統計モデルと言うことが多い)。

さて、今得られているデータとして、

と

の組が

組あるものとする。単回帰モデルを今得られているすべてのデータに当てはめることを考えると、

番目の組は以下のように表される。

これで、あとは

と

をデータから推定すればよい。また、それぞれの

のばらつき(分散)

も通常は分からないので、データから推測することになる。これらを推定するための方法として、最小二乗法(Least squares method)と最尤法(Maximum likelihood method)という方法が代表的である。今回は最小二乗法による推定を説明したいと思う。単回帰モデルの場合(正確に言えば、目的変数の分布が

正規分布の場合)

と

の推定結果は同じになる。

なお、各

どうしは独立であることを仮定している。例えば別々の個人から得られたデータであれば通常は独立と考えても問題はないが、同じ個人から何度も測定したデータであればそういう訳にはいかない。この場合にはもっと込み入った方法が必要になる。

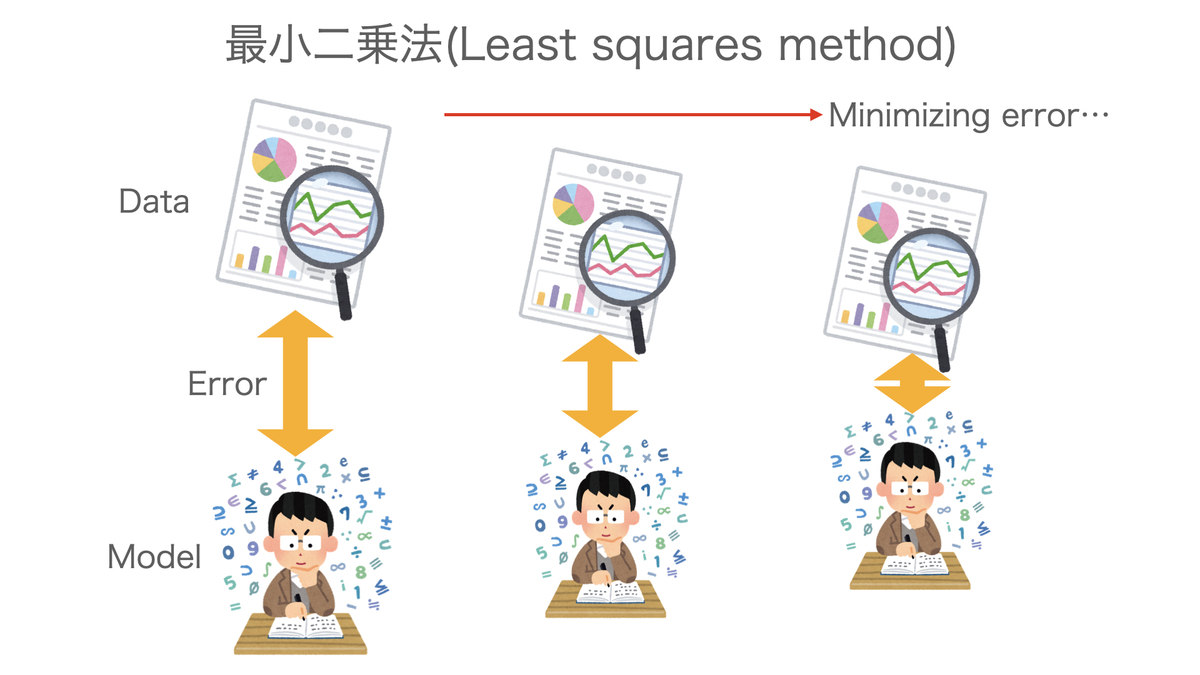

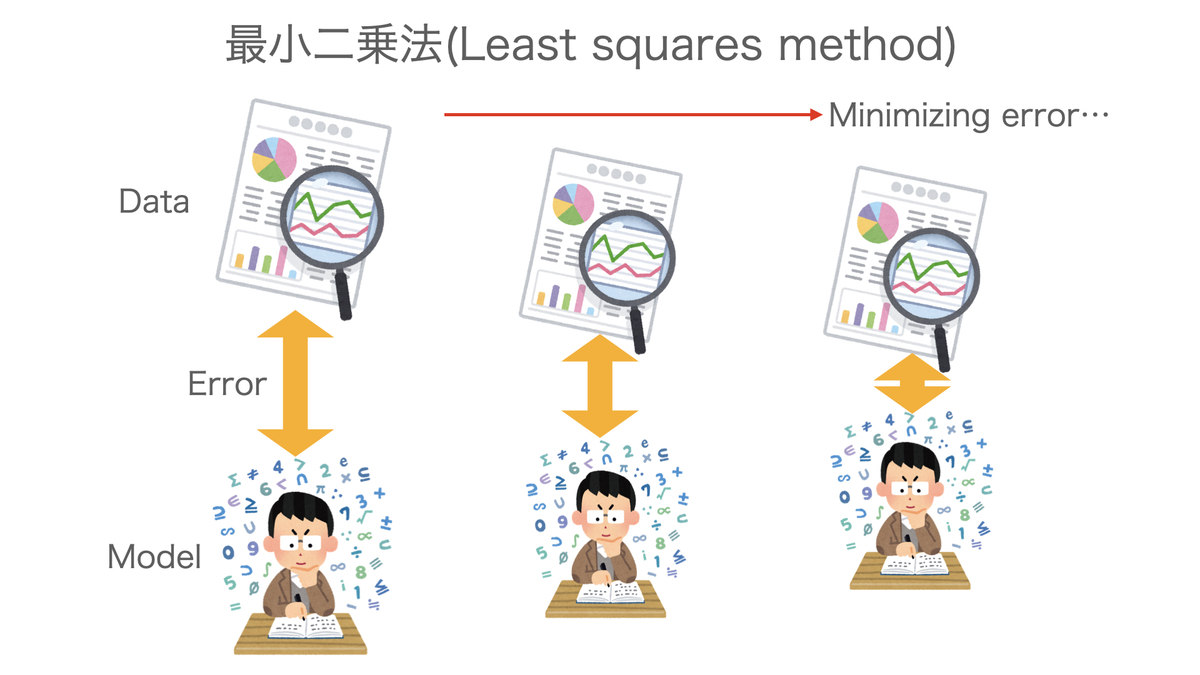

最小二乗法

では、最小二乗法によって未知の値 をデータから推測する方法を述べる。

をデータから推測する方法を述べる。

最小二乗法とは、まさに前回説明したイメージの通り、データとのズレを最小にするようにして最適な統計モデルを決定する方法である。

正確には、次のように実際のデータ とモデルで推定される期待値

とモデルで推定される期待値![E[ y_i | x_i ] = \alpha + \beta x_i](https://chart.apis.google.com/chart?cht=tx&chl=%20E%5B%20y_i%20%7C%20x_i%20%5D%20%3D%20%5Calpha%20%2B%20%5Cbeta%20x_i) との差である偏差(Deviation)を二乗したものの合計

との差である偏差(Deviation)を二乗したものの合計

を最小にすることを考える。この合計を偏差平方和(Sum of squared deviation)という。

は

と

それぞれの二次関数になっているので、最小にするような

と

は「

微分して0とおく」という操作をすれば計算できる(傾きがゼロになる点が最小になる)。

これを整理すると、正規方程式と呼ばれる

連立方程式が得られる。

まず

の方から解いていこう。

の最適解

は

となる。ただし

はそれぞれ

の標本平均である。これは、

と

の標本共分散を

の標本分散で割ったものに等しい。

この結果を得た上で

の最適解

を求めると

となる。あとは、データから

を算出することができる。

これらの最適解(推

定量)は、期待値をとると(つまり、真の値は)

に一致する。つまり、最小二乗法で計算すると、未知の

は偏りなく推定ができることになる。このような推

定量を不偏推

定量という。

最後にばらつきのパラメータ

は、推定した

を使って次のように推定できる。これも期待値が

に一致する不偏推

定量である。

なお、最尤法で

を推定する場合、

の推

定量は不偏ではないことが知られている。しかし、違いは

なので、サンプル数が大きければそこまでの違いはない。

まとめ

単回帰分析のモデルを数学的に定義し、推定方法の一つである最小二乗法について説明した。最小二乗法は「データとモデルとのズレ」を小さくするという単純な問題に帰着するので確率分布のことが表に出てこないが、もっと様々な種類のデータ(二値のデータやカウントデータなど)をモデルで表現するためには、適切な確率分布を考えていく必要があり、そのような場合には最尤法が出番となる。

今回の参考文献は以下の通り。

[1] 鈴木武, 山田作太郎(1996), "数理統計学", 内田老鶴圃.

[2] Annette J. Dobson(2008), "一般化線形モデル入門", 共立出版.

で目的変数

を表現する単回帰分析とは、

は正規分布に従うと仮定し、

を推定する

は正確には

による

の条件付き期待値であり、すでに観測されている

の値によって

の真の状態を推定することから「

による条件付き」という形になる。よって、

は確率的にばらつくことを前提としている一方、

は固定した値と考える(

もばらつきを持っていると想定する方法も当然ある)。

によって説明される

の真の状態(期待値)は、

の一次関数であると仮定している:

をデータから推測する方法を述べる。

とモデルで推定される期待値

との差である偏差(Deviation)を二乗したものの合計